Kosmologisches Modell des frühen Universums – das Zeitalter der Strahlung. Hypothese eines mehrblättrigen Modells des Universums. Benötigen Sie Hilfe beim Studium eines Themas?

Am Anfang war das Universum ein sich ausdehnender Klumpen aus Leere. Sein Zusammenbruch führte zum Urknall, in dessen feuerspeiendem Plasma die ersten chemischen Elemente entstanden. Dann komprimierte die Schwerkraft die kühlenden Gaswolken über Millionen von Jahren. Und dann leuchteten die ersten Sterne auf und erleuchteten ein grandioses Universum mit Billionen blasser Galaxien ... Dieses Weltbild, gestützt durch die größten astronomischen Entdeckungen des 20. Jahrhunderts, steht auf einer soliden theoretischen Grundlage. Aber es gibt Spezialisten, denen das nicht gefällt. Sie suchen beharrlich nach Schwachstellen darin und hoffen, dass eine andere Kosmologie die aktuelle ersetzen wird.

In den frühen 1920er Jahren fand der St. Petersburger Wissenschaftler Alexander Friedman eine Lösung für die Gleichungen der Allgemeinen Relativitätstheorie (GTR), die das instationäre expandierende Universum beschreiben, wobei er der Einfachheit halber davon ausging, dass Materie den gesamten Raum gleichmäßig ausfüllt. Selbst Einstein nahm diese Entdeckung nicht ernst, da er glaubte, dass das Universum ewig und unveränderlich sein müsse. Um ein solches Universum zu beschreiben, führte er sogar einen speziellen „Anti-Schwerkraft“-Lambda-Term in die allgemeinen Relativitätsgleichungen ein. Friedman starb bald an Typhus und seine Entscheidung geriet in Vergessenheit. Edwin Hubble beispielsweise, der am Mount Wilson Observatory am größten 100-Zoll-Teleskop der Welt arbeitete, hatte noch nichts von diesen Ideen gehört.

Bis 1929 hatte Hubble die Entfernungen zu mehreren Dutzend Galaxien gemessen und beim Vergleich mit zuvor erhaltenen Spektren unerwartet festgestellt, dass ihre Spektrallinien umso rotverschobener sind, je weiter eine Galaxie entfernt ist. Der einfachste Weg, die Rotverschiebung zu erklären, war der Doppler-Effekt. Doch dann stellte sich heraus, dass sich alle Galaxien schnell von uns entfernten. Es war so seltsam, dass der Astronom Fritz Zwicky eine sehr kühne Hypothese des „müden Lichts“ aufstellte, wonach sich nicht Galaxien von uns entfernen, sondern Lichtquanten, die während einer langen Reise einen gewissen Widerstand gegen ihre Bewegung erfahren und allmählich verlieren Energie und Rotwerden. Dann erinnerten sie sich natürlich an die Idee, den Weltraum zu erweitern, und es stellte sich heraus, dass nicht weniger seltsame neue Beobachtungen gut in diese seltsame vergessene Theorie passten. Friedmans Modell profitierte auch von der Tatsache, dass der Ursprung der Rotverschiebung darin dem üblichen Doppler-Effekt sehr ähnlich sieht: Noch heute verstehen nicht alle Astronomen, dass die „Streuung“ von Galaxien im Weltraum keineswegs dasselbe ist wie die Expansion des Weltraums selbst mit „eingefrorenen“ Galaxien hinein.

Die Hypothese vom „müden Licht“ verschwand Ende der 1930er Jahre stillschweigend von der Bildfläche, als Physiker feststellten, dass ein Photon nur durch die Wechselwirkung mit anderen Teilchen Energie verliert und sich in diesem Fall die Richtung seiner Bewegung zwangsläufig zumindest geringfügig ändert. Die Bilder entfernter Galaxien im „müden Licht“-Modell sollten also wie im Nebel verschwimmen, sind aber recht deutlich sichtbar. Infolgedessen hat das Friedmann-Modell des Universums, eine Alternative zu allgemein akzeptierten Ideen, in letzter Zeit die Aufmerksamkeit aller auf sich gezogen. (Bis zu seinem Lebensende, im Jahr 1953, gab Hubble jedoch selbst zu, dass die Ausdehnung des Weltraums nur ein scheinbarer Effekt sein konnte.)

Zweimal alternativer Standard

Aber da sich das Universum ausdehnt, bedeutet das, dass es vorher dichter war. Friedmans Schüler, der Kernphysiker Georgi Gamow, kehrte seine Entwicklung gedanklich um und kam zu dem Schluss, dass das frühe Universum so heiß war, dass darin thermonukleare Fusionsreaktionen stattfanden. Gamow versuchte mit ihnen die beobachtete Verbreitung chemischer Elemente zu erklären, doch es gelang ihm, nur wenige Arten leichter Kerne im Primärkessel zu „kochen“. Es stellte sich heraus, dass die Welt neben Wasserstoff 23-25 % Helium, ein Hundertstel Prozent Deuterium und ein Milliardstel Lithium enthalten sollte. Die Theorie der Synthese schwererer Elemente in Sternen wurde später gemeinsam mit seinen Kollegen von Gamows Konkurrenten, dem Astrophysiker Fred Hoyle, entwickelt.

Im Jahr 1948 sagte Gamow außerdem voraus, dass eine beobachtbare Spur vom heißen Universum zurückbleiben sollte – gekühlte Mikrowellenstrahlung mit einer Temperatur von mehreren Grad Kelvin, die aus allen Himmelsrichtungen kommt. Leider wiederholte Gamows Vorhersage das Schicksal von Friedmans Modell: Niemand hatte es eilig, nach seiner Strahlung zu suchen. Die Theorie eines heißen Universums schien zu extravagant, um teure Experimente zu ihrer Überprüfung durchzuführen. Darüber hinaus wurden darin Parallelen zur göttlichen Schöpfung gesehen, von der sich viele Wissenschaftler distanzierten. Es endete damit, dass Gamow die Kosmologie aufgab und sich der damals aufkommenden Genetik zuwandte.

In den 1950er Jahren gewann eine neue Version der Theorie eines stationären Universums an Popularität, die von demselben Fred Hoyle zusammen mit dem Astrophysiker Thomas Gold und dem Mathematiker Hermann Bondi entwickelt wurde. Unter dem Druck von Hubbles Entdeckung akzeptierten sie die Expansion des Universums, nicht jedoch seine Entwicklung. Ihrer Theorie zufolge geht die Ausdehnung des Weltraums mit der spontanen Bildung von Wasserstoffatomen einher, sodass die durchschnittliche Dichte des Universums unverändert bleibt. Dies ist natürlich ein Verstoß gegen das Energieerhaltungsgesetz, aber ein äußerst unbedeutender – nicht mehr als ein Wasserstoffatom pro Milliarde Jahre pro Kubikmeter Raum. Hoyle nannte sein Modell „die Theorie der kontinuierlichen Schöpfung“ und führte ein spezielles C-Feld (von der englischen Schöpfung – Schöpfung) mit Unterdruck ein, das das Universum zum Aufblasen zwang und gleichzeitig eine konstante Materiedichte aufrechterhielt. Im Gegensatz zu Gamow erklärte Hoyle die Entstehung aller Elemente, auch der leichten, durch thermonukleare Prozesse in Sternen.

Der von Gamow vorhergesagte kosmische Mikrowellenhintergrund wurde fast 20 Jahre später zufällig bemerkt. Seine Entdecker erhielten den Nobelpreis und das heiße Friedmann-Gamow-Universum verdrängte schnell konkurrierende Hypothesen. Hoyle gab jedoch nicht auf und argumentierte zur Verteidigung seiner Theorie, dass der Mikrowellenhintergrund von fernen Sternen erzeugt werde, deren Licht vom kosmischen Staub gestreut und wieder abgestrahlt werde. Dann sollte das Leuchten des Himmels zwar fleckig, aber nahezu gleichmäßig sein. Nach und nach wurden Daten über die chemische Zusammensetzung von Sternen und kosmischen Wolken gesammelt, die auch mit Gams Modell der primären Nukleosynthese übereinstimmten.

So wurde die zweifach alternative Theorie des Urknalls allgemein akzeptiert oder, wie man heute sagt, zum wissenschaftlichen Mainstream. Und jetzt wird den Schulkindern beigebracht, dass Hubble die Explosion des Universums entdeckt hat (und nicht die Abhängigkeit der Rotverschiebung von der Entfernung) und dass kosmische Mikrowellenstrahlung mit der leichten Hand des sowjetischen Astrophysikers Joseph Samuilovich Shklovsky zu einer Reliktstrahlung wird. Das Modell des heißen Universums wird buchstäblich auf der Ebene der Sprache in die Köpfe der Menschen „eingenäht“.

Vier Ursachen für Rotverschiebung

Welches sollten Sie wählen, um das Hubble-Gesetz zu erklären – die Abhängigkeit der Rotverschiebung von der Entfernung?

|

Laborgeprüft |

Nicht im Labor getestet |

|

|

Frequenzänderung |

1. Doppler-Effekt Tritt auf, wenn die Strahlungsquelle entfernt wird. Seine Lichtwellen erreichen unseren Empfänger etwas seltener, als sie von der Quelle ausgesendet werden. Der Effekt wird in der Astronomie häufig genutzt, um die Bewegungsgeschwindigkeit von Objekten entlang der Sichtlinie zu messen. |

3. Raumerweiterung Nach der Allgemeinen Relativitätstheorie können sich die Eigenschaften des Raumes selbst im Laufe der Zeit ändern. Vergrößert sich dadurch der Abstand zwischen Quelle und Empfänger, so werden die Lichtwellen ähnlich wie beim Doppler-Effekt gedehnt. |

|

Energiewandel |

2. Gravitationsrotverschiebung Wenn ein Lichtquant aus einem Gravitationsschacht entweicht, verbraucht es Energie, um die Schwerkraft zu überwinden. Eine Abnahme der Energie entspricht einer Abnahme der Strahlungsfrequenz und ihrer Verschiebung zur roten Seite des Spektrums. |

4. Leichte Müdigkeit Möglicherweise geht die Bewegung eines Lichtquants im Raum mit einer Art „Reibung“ einher, also einem Energieverlust proportional zum zurückgelegten Weg. Dies war eine der ersten Hypothesen zur Erklärung der kosmologischen Rotverschiebung. |

Unter den Fundamenten graben

Aber die menschliche Natur ist so beschaffen, dass es sofort Menschen gibt, die streiten wollen, sobald sich eine andere unbestreitbare Idee in der Gesellschaft durchsetzt. Die Kritik an der Standardkosmologie kann in konzeptionelle Kritik, die auf die Unvollkommenheit ihrer theoretischen Grundlagen hinweist, und astronomische Kritik, die spezifische Fakten und Beobachtungen zitiert, die schwer zu erklären sind, unterteilt werden.

Das Hauptziel konzeptioneller Angriffe ist natürlich die Allgemeine Relativitätstheorie (GR). Einstein gab eine überraschend schöne Beschreibung der Schwerkraft und identifizierte sie mit der Krümmung der Raumzeit. Aus der Allgemeinen Relativitätstheorie folgt jedoch die Existenz von Schwarzen Löchern, seltsamen Objekten, in deren Zentrum Materie zu einem Punkt unendlicher Dichte komprimiert ist. In der Physik weist das Erscheinen der Unendlichkeit immer auf die Grenzen der Anwendbarkeit einer Theorie hin. Bei ultrahohen Dichten muss die allgemeine Relativitätstheorie durch die Quantengravitation ersetzt werden. Doch alle Versuche, die Prinzipien der Quantenphysik in die Allgemeine Relativitätstheorie einzuführen, scheiterten, was die Physiker dazu zwingt, nach alternativen Gravitationstheorien zu suchen. Dutzende davon wurden im 20. Jahrhundert erbaut. Die meisten hielten experimentellen Tests nicht stand. Aber ein paar Theorien gelten immer noch. Dazu gehört beispielsweise die Feldtheorie der Schwerkraft des Akademiemitglieds Logunov, in der es keinen gekrümmten Raum gibt, keine Singularitäten entstehen, das heißt, es gibt keine Schwarzen Löcher oder den Urknall. Wo immer die Vorhersagen solcher alternativen Gravitationstheorien experimentell überprüft werden können, stimmen sie mit denen der allgemeinen Relativitätstheorie überein, und nur in extremen Fällen – bei extrem hohen Dichten oder in sehr großen kosmologischen Entfernungen – weichen ihre Schlussfolgerungen voneinander ab. Das bedeutet, dass die Struktur und Entwicklung des Universums unterschiedlich sein muss.

Neue Kosmographie

Es war einmal, als Johannes Kepler versuchte, die Beziehungen zwischen den Radien der Planetenbahnen theoretisch zu erklären, indem er regelmäßige Polyeder ineinander verschachtelte. Die darin beschriebenen und eingeschriebenen Sphären schienen ihm der direkteste Weg zur Entschlüsselung der Struktur des Universums zu sein – „Das kosmographische Geheimnis“, wie er sein Buch nannte. Basierend auf den Beobachtungen von Tycho Brahe verwarf er später die alte Idee der himmlischen Perfektion von Kreisen und Kugeln und kam zu dem Schluss, dass sich die Planeten in Ellipsen bewegen.

Auch viele moderne Astronomen stehen den spekulativen Konstruktionen der Theoretiker skeptisch gegenüber und lassen sich lieber vom Blick in den Himmel inspirieren. Und dort können Sie sehen, dass unsere Galaxie, die Milchstraße, Teil eines kleinen Clusters namens Lokale Galaxiengruppe ist, der vom Zentrum einer riesigen Galaxienwolke im Sternbild Jungfrau angezogen wird, die als Lokaler Superhaufen bekannt ist. Bereits 1958 veröffentlichte der Astronom George Abel einen Katalog von 2.712 Galaxienhaufen am Nordhimmel, die wiederum zu Superhaufen gruppiert sind.

Stimmen Sie zu, es sieht nicht wie ein Universum aus, das gleichmäßig mit Materie gefüllt ist. Ohne Homogenität im Friedman-Modell ist es jedoch unmöglich, ein Expansionsregime zu erhalten, das dem Hubble-Gesetz entspricht. Und auch die erstaunliche Glätte des Mikrowellenhintergrunds lässt sich nicht erklären. Daher wurde im Namen der Schönheit der Theorie die Homogenität des Universums zum kosmologischen Prinzip erklärt und von den Beobachtern erwartet, dass sie dies bestätigen. Natürlich dominiert bei kleinen Entfernungen nach kosmologischen Maßstäben – hundertmal so groß wie die Milchstraße – die Anziehungskraft zwischen Galaxien: Sie bewegen sich auf einer Umlaufbahn, kollidieren und verschmelzen. Aber ab einer bestimmten Entfernungsskala muss das Universum einfach homogen werden.

In den 1970er Jahren ließen sich Beobachtungen noch nicht mit Sicherheit sagen, ob Strukturen existierten, die größer als ein paar Dutzend Megaparsecs waren, und die Worte „großräumige Homogenität des Universums“ klangen wie ein schützendes Mantra von Friedmanns Kosmologie. Doch Anfang der 1990er Jahre hatte sich die Situation dramatisch verändert. An der Grenze der Sternbilder Fische und Wal wurde ein etwa 50 Megaparsec großer Superhaufenkomplex entdeckt, zu dem auch der Lokale Superhaufen gehört. Im Sternbild Hydra entdeckten sie zunächst den Großen Attraktor mit einer Größe von 60 Megaparsec und dahinter einen riesigen, dreimal größeren Shapley-Superhaufen. Und das sind keine isolierten Objekte. Zur gleichen Zeit beschrieben Astronomen die Große Mauer, einen Komplex mit einer Länge von 150 Megaparsec, und die Liste wird immer länger.

Bis zum Ende des Jahrhunderts wurde die Produktion von 3D-Karten des Universums in Betrieb genommen. In einer Teleskopaufnahme werden Spektren von Hunderten von Galaxien aufgenommen. Dazu platziert ein Robotermanipulator Hunderte von optischen Fasern in der Brennebene der Weitwinkel-Schmidt-Kamera an bekannten Koordinaten und überträgt das Licht jeder einzelnen Galaxie an das Spektrographielabor. Die bisher größte SDSS-Durchmusterung hat bereits die Spektren und Rotverschiebungen von einer Million Galaxien bestimmt. Und die größte bekannte Struktur im Universum bleibt die Great Wall of Sloan, die laut der vorherigen CfA-II-Untersuchung 2003 entdeckt wurde. Seine Länge beträgt 500 Megaparsec, was 12 % der Entfernung zum Horizont des Friedmann-Universums entspricht.

Neben Materieansammlungen wurden auch viele verlassene Regionen des Weltraums entdeckt – Hohlräume, in denen es weder Galaxien noch mysteriöse dunkle Materie gibt. Viele von ihnen sind größer als 100 Megaparsec, und 2007 meldete das amerikanische National Radio Astronomy Observatory die Entdeckung eines Großen Hohlraums mit einem Durchmesser von etwa 300 Megaparsec.

Die bloße Existenz solch grandioser Strukturen stellt eine Herausforderung für die Standardkosmologie dar, in der sich Inhomogenitäten aufgrund der gravitativen Ansammlung von Materie aufgrund winziger Dichteschwankungen, die vom Urknall übrig geblieben sind, entwickeln. Bei den beobachteten natürlichen Bewegungsgeschwindigkeiten von Galaxien können sie während der gesamten Lebensdauer des Universums nicht mehr als ein Dutzend oder zwei Megaparsec zurücklegen. Und wie können wir dann die Konzentration einer Substanz erklären, die Hunderte von Megaparsec misst?

Dunkle Wesen

Streng genommen erklärt Friedmans Modell „in seiner reinen Form“ nicht die Entstehung selbst kleiner Strukturen – Galaxien und Cluster, es sei denn, wir fügen ihm eine besondere, nicht beobachtbare Einheit hinzu, die 1933 von Fritz Zwicky erfunden wurde. Bei der Untersuchung des Coma-Haufens entdeckte er, dass sich seine Galaxien so schnell bewegten, dass sie leicht davonfliegen müssten. Warum zerfällt der Cluster nicht? Zwicky vermutete, dass seine Masse viel größer war als anhand leuchtender Quellen angenommen. So entstand in der Astrophysik verborgene Masse, die heute Dunkle Materie genannt wird. Ohne sie ist es unmöglich, die Dynamik galaktischer Scheiben und Galaxienhaufen, die Lichtbeugung beim Passieren dieser Galaxienhaufen und ihren eigentlichen Ursprung zu beschreiben. Es wird geschätzt, dass es fünfmal mehr dunkle Materie als normale leuchtende Materie gibt. Es wurde bereits festgestellt, dass es sich nicht um dunkle Planetoiden, keine Schwarzen Löcher und keine bekannten Elementarteilchen handelt. Dunkle Materie besteht wahrscheinlich aus einigen schweren Teilchen, die nur an schwachen Wechselwirkungen teilnehmen.

Kürzlich entdeckte das italienisch-russische Satellitenexperiment PAMELA einen seltsamen Überschuss an energiereichen Positronen in der kosmischen Strahlung. Astrophysiker kennen keine geeignete Quelle für Positronen und vermuten, dass sie das Produkt einer Reaktion mit Teilchen der dunklen Materie sein könnten. Wenn ja, dann könnte Gamows Theorie der ursprünglichen Nukleosynthese gefährdet sein, da sie nicht von der Anwesenheit einer großen Anzahl unbekannter schwerer Teilchen im frühen Universum ausging.

Die geheimnisvolle dunkle Energie musste an der Wende vom 20. zum 21. Jahrhundert dringend in das Standardmodell des Universums aufgenommen werden. Kurz zuvor wurde eine neue Methode zur Bestimmung von Entfernungen zu entfernten Galaxien getestet. Die „Standardkerze“ darin waren die Explosionen von Supernovae einer besonderen Art, die auf dem Höhepunkt des Ausbruchs immer fast die gleiche Leuchtkraft haben. Ihre scheinbare Helligkeit wird verwendet, um die Entfernung zur Galaxie zu bestimmen, in der sich die Katastrophe ereignete. Jeder erwartete, dass die Messungen eine leichte Verlangsamung der Expansion des Universums unter dem Einfluss der Eigengravitation seiner Materie zeigen würden. Mit großer Überraschung stellten die Astronomen fest, dass sich die Expansion des Universums im Gegenteil beschleunigt! Dunkle Energie wurde erfunden, um die universelle kosmische Abstoßung zu erzeugen, die das Universum aufbläht. Tatsächlich ist es nicht vom Lambda-Term in Einsteins Gleichungen und, was noch lustiger ist, vom C-Feld aus der Bondi-Gold-Hoyle-Theorie eines stationären Universums, in der Vergangenheit der Hauptkonkurrent der Friedmann-Gamow-Kosmologie, nicht zu unterscheiden. Auf diese Weise wandern künstliche spekulative Ideen zwischen Theorien und helfen ihnen, unter dem Druck neuer Fakten zu überleben.

Wenn Friedmans ursprüngliches Modell nur einen Parameter hatte, der aus Beobachtungen bestimmt wurde (die durchschnittliche Materiedichte im Universum), dann nahm mit dem Aufkommen „dunkler Wesen“ die Zahl der „Abstimmungs“-Parameter merklich zu. Dabei handelt es sich nicht nur um die Mengenverhältnisse der dunklen „Zutaten“, sondern auch um deren willkürlich angenommene physikalische Eigenschaften, etwa die Fähigkeit, an verschiedenen Interaktionen teilzunehmen. Stimmt es nicht, dass das alles an die Theorie des Ptolemäus erinnert? Auch ihm wurden immer mehr Epizykel hinzugefügt, um Übereinstimmung mit den Beobachtungen zu erreichen, bis er unter der Last seines eigenen überkomplizierten Designs zusammenbrach.

DIY-Universum

In den letzten 100 Jahren ist eine große Vielfalt an kosmologischen Modellen entstanden. Wurde früher jeder von ihnen als eine einzigartige physikalische Hypothese wahrgenommen, ist die Haltung jetzt prosaischer geworden. Um ein kosmologisches Modell zu erstellen, müssen Sie sich mit drei Dingen auseinandersetzen: der Theorie der Schwerkraft, von der die Eigenschaften des Raums abhängen, der Verteilung der Materie und der physikalischen Natur der Rotverschiebung, aus der die Abhängigkeit abgeleitet wird: Entfernung – Rotverschiebung R(z). Dadurch wird die Kosmographie des Modells festgelegt, die es ermöglicht, verschiedene Effekte zu berechnen: wie die Helligkeit einer „Standardkerze“, die Winkelgröße eines „Standardmeters“, die Dauer einer „Standardsekunde“ und die Oberflächenhelligkeit einer „Referenzgalaxie“ ändern sich mit der Entfernung (oder besser gesagt mit der Rotverschiebung). Es bleibt nur noch, in den Himmel zu schauen und zu verstehen, welche Theorie die richtigen Vorhersagen liefert.

Stellen Sie sich vor, Sie sitzen abends in einem Hochhaus am Fenster und blicken auf das Lichtermeer der Stadt, das sich darunter erstreckt. In der Ferne gibt es weniger davon. Warum? Vielleicht gibt es dort schlechte Außenbezirke, oder die Bebauung ist sogar ganz zum Erliegen gekommen. Oder vielleicht ist das Licht der Laternen durch Nebel oder Smog gedimmt. Oder die Krümmung der Erdoberfläche beeinflusst sie und entfernte Lichter gehen einfach über den Horizont hinaus. Für jede Option können Sie die Abhängigkeit der Anzahl der Lichter von der Entfernung berechnen und eine passende Erklärung finden. Auf diese Weise untersuchen Kosmologen entfernte Galaxien und versuchen, das beste Modell des Universums auszuwählen.

Damit der kosmologische Test funktioniert, ist es wichtig, „Standard“-Objekte zu finden und den Einfluss aller Störungen zu berücksichtigen, die ihr Aussehen verfälschen. Beobachtende Kosmologen kämpfen seit acht Jahrzehnten damit. Nehmen wir zum Beispiel den Winkelgrößentest. Wenn unser Raum euklidisch, also nicht gekrümmt ist, nimmt die scheinbare Größe der Galaxien umgekehrt proportional zur Rotverschiebung z ab. In Friedmanns Modell mit gekrümmtem Raum nehmen die Winkelgrößen von Objekten langsamer ab und wir sehen Galaxien, die etwas größer sind, wie Fische in einem Aquarium. Es gibt sogar ein Modell (Einstein arbeitete in den frühen Stadien damit), bei dem Galaxien zunächst kleiner werden, wenn sie sich entfernen, und dann wieder zu wachsen beginnen. Das Problem besteht jedoch darin, dass wir entfernte Galaxien so sehen, wie sie in der Vergangenheit waren, und dass sich ihre Größe im Laufe der Evolution ändern kann. Darüber hinaus erscheinen Nebelflecken aus großer Entfernung kleiner – aufgrund der Tatsache, dass ihre Ränder schwer zu erkennen sind.

Es ist äußerst schwierig, den Einfluss solcher Effekte zu berücksichtigen, und daher hängt das Ergebnis eines kosmologischen Tests oft von den Vorlieben eines bestimmten Forschers ab. In einer Vielzahl veröffentlichter Arbeiten findet man Tests, die eine Vielzahl kosmologischer Modelle sowohl bestätigen als auch widerlegen. Und nur die Professionalität des Wissenschaftlers bestimmt, welchen von ihnen er glaubt und welchen nicht. Hier nur ein paar Beispiele.

Im Jahr 2006 testete ein internationales Team aus drei Dutzend Astronomen, ob sich entfernte Supernova-Explosionen über die Zeit ausdehnten, wie es Friedmanns Modell erfordert. Sie stimmten der Theorie voll und ganz zu: Blitze verlängern sich genau so oft, wie die Frequenz des von ihnen ausgehenden Lichts abnimmt – Zeitdilatation in der Allgemeinen Relativitätstheorie hat auf alle Prozesse den gleichen Effekt. Dieses Ergebnis hätte ein weiterer letzter Nagel im Sarg der Theorie eines stationären Universums sein können (das erste wurde vor 40 Jahren von Stephen Hawking als kosmischer Mikrowellenhintergrund bezeichnet), doch 2009 veröffentlichte der amerikanische Astrophysiker Eric Lerner genau die gegenteiligen Ergebnisse mit einer anderen Methode gewonnen. Er nutzte den 1930 von Richard Tolman erfundenen Oberflächenhelligkeitstest für Galaxien, um gezielt zwischen einem expandierenden und einem statischen Universum zu entscheiden. Im Friedmann-Modell nimmt die Oberflächenhelligkeit von Galaxien mit zunehmender Rotverschiebung sehr schnell ab, im euklidischen Raum mit „müdem Licht“ verläuft der Zerfall deutlich langsamer. Bei z = 1 (wo Galaxien laut Friedman etwa halb so jung sind wie die in unserer Nähe) beträgt der Unterschied das Achtfache, und bei z = 5, was nahe an der Grenze der Leistungsfähigkeit des Hubble-Weltraumteleskops liegt, beträgt er sogar das Achtfache ist mehr als 200-fach. Der Test zeigte, dass die Daten nahezu perfekt mit dem „Müde-Licht“-Modell übereinstimmen und stark von denen von Friedman abweichen.

Grund zum Zweifel

Die beobachtende Kosmologie hat viele Daten gesammelt, die Zweifel an der Richtigkeit des vorherrschenden kosmologischen Modells aufkommen lassen, das nach der Hinzufügung dunkler Materie und Energie als LCDM (Lambda – Kalte Dunkle Materie) bezeichnet wurde. Ein potenzielles Problem für LCDM ist der schnelle Anstieg der Rekordrotverschiebungen erkannter Objekte. Masanori Iye, ein Mitarbeiter des japanischen Nationalen Astronomischen Observatoriums, untersuchte, wie die rekordverdächtigen offenen Rotverschiebungen von Galaxien, Quasaren und Gammastrahlenausbrüchen (den stärksten Explosionen und den am weitesten entfernten Leuchtfeuern im beobachtbaren Universum) wuchsen. Bis 2008 hatten sie alle bereits die Schwelle von z = 6 überschritten, und der Rekord z an Gammastrahlenausbrüchen wuchs besonders schnell. 2009 stellten sie einen weiteren Rekord auf: z = 8,2. In Friedmans Modell entspricht dies einem Alter von etwa 600 Millionen Jahren nach dem Urknall und passt bis zum Äußersten zu bestehenden Theorien zur Galaxienentstehung: mehr, und sie werden einfach keine Zeit mehr haben, sich zu bilden. Unterdessen scheint der Fortschritt bei den Z-Indikatoren nicht aufzuhören – alle warten auf Daten der neuen Weltraumteleskope Herschel und Planck, die im Frühjahr 2009 gestartet wurden. Wenn Objekte mit z = 15 oder 20 auftauchen, kommt es zu einer ausgewachsenen LCDM-Krise.

Ein weiteres Problem wurde bereits 1972 von Alan Sandage, einem der angesehensten beobachtenden Kosmologen, bemerkt. Es stellt sich heraus, dass das Hubble-Gesetz in der unmittelbaren Umgebung der Milchstraße nur allzu gut gilt. Innerhalb weniger Megaparsecs von uns ist die Materie äußerst inhomogen verteilt, doch die Galaxien scheinen dies nicht zu bemerken. Ihre Rotverschiebungen sind genau proportional zu ihren Entfernungen, mit Ausnahme derjenigen, die sehr nahe an den Zentren großer Haufen liegen. Die chaotischen Geschwindigkeiten von Galaxien scheinen durch etwas gedämpft zu werden. In Analogie zur thermischen Bewegung von Molekülen wird dieses Paradox manchmal als anomale Kälte des Hubble-Flusses bezeichnet. Es gibt keine umfassende Erklärung für dieses Paradoxon im LCDM, aber es erhält eine natürliche Erklärung im „müden Licht“-Modell. Alexander Raikov vom Pulkowo-Observatorium stellte die Hypothese auf, dass die Rotverschiebung von Photonen und die Dämpfung der chaotischen Geschwindigkeiten von Galaxien eine Manifestation desselben kosmologischen Faktors sein könnten. Und der gleiche Grund könnte die Anomalie in der Bewegung der amerikanischen interplanetaren Sonden Pioneer 10 und Pioneer 11 erklären. Als sie das Sonnensystem verließen, erlebten sie eine kleine, unerklärliche Verlangsamung, genau das richtige Maß, um numerisch die Kälte des Hubble-Stroms zu erklären.

Eine Reihe von Kosmologen versucht zu beweisen, dass die Materie im Universum nicht gleichmäßig, sondern fraktal verteilt ist. Dies bedeutet, dass das Universum unabhängig von der Skala, die wir betrachten, immer eine Abwechslung von Clustern und Hohlräumen der entsprechenden Ebene aufweisen wird. Der erste, der dieses Thema ansprach, war 1987 der italienische Physiker Luciano Piotroneiro. Und vor einigen Jahren veröffentlichten der St. Petersburger Kosmologe Yuri Baryshev und Pekka Teerikorpi aus Finnland eine umfangreiche Monographie „Die fraktale Struktur des Universums“. In einer Reihe wissenschaftlicher Artikel wird behauptet, dass bei Rotverschiebungsuntersuchungen die fraktale Natur der Galaxienverteilung bis zu einem Maßstab von 100 Megaparsec zuverlässig aufgedeckt und die Heterogenität bis zu 500 Megaparsec und mehr verfolgt wird. Und kürzlich entdeckte Alexander Raikov zusammen mit Viktor Orlov von der Staatlichen Universität St. Petersburg Anzeichen einer fraktalen Verteilung im Katalog der Gammastrahlenausbrüche auf Skalen bis z = 3 (also nach dem Friedmann-Modell in den meisten). das sichtbare Universum). Sollte sich dies bestätigen, steht die Kosmologie vor einer großen Umwälzung. Die Fraktalität verallgemeinert den Begriff der Homogenität, der aus Gründen der mathematischen Einfachheit als Grundlage der Kosmologie des 20. Jahrhunderts herangezogen wurde. Heutzutage werden Fraktale von Mathematikern aktiv untersucht und regelmäßig neue Theoreme bewiesen. Die Fraktalität der großräumigen Struktur des Universums kann zu sehr unerwarteten Konsequenzen führen, und wer weiß, ob uns radikale Veränderungen im Bild des Universums und seiner Entwicklung erwarten?

Schrei der Seele

Und doch, egal wie inspiriert kosmologische „Dissidenten“ von solchen Beispielen sind, gibt es heute keine kohärente und gut entwickelte Theorie der Struktur und Entwicklung des Universums, die sich vom Standard-LCDM unterscheidet. Was zusammenfassend als alternative Kosmologie bezeichnet wird, besteht aus einer Reihe von Behauptungen, die zu Recht von Befürwortern des allgemein akzeptierten Konzepts aufgestellt werden, sowie aus einer Reihe vielversprechender Ideen unterschiedlicher Ausgereiftheit, die in der Zukunft bei einem starken alternativen Forschungsprogramm nützlich sein könnten entsteht.

Viele Befürworter alternativer Ansichten neigen dazu, einzelne Ideen oder Gegenbeispiele zu stark hervorzuheben. Sie hoffen, dass durch den Nachweis der Schwierigkeiten des Standardmodells dieses aufgegeben werden kann. Doch wie der Wissenschaftsphilosoph Imre Lakatos argumentierte, können weder Experimente noch Paradoxe eine Theorie zerstören. Nur eine neue, bessere Theorie tötet eine Theorie. Für eine alternative Kosmologie gibt es noch nichts zu bieten.

Aber wo sollen neue gravierende Entwicklungen herkommen, beschweren sich die „Alternativen“, wenn überall auf der Welt, in Förderausschüssen, in den Redaktionen wissenschaftlicher Fachzeitschriften und in Kommissionen zur Verteilung der Beobachtungszeit von Teleskopen die Mehrheit Befürworter des Standards sind? Kosmologie. Sie, so sagen sie, blockieren einfach die Zuweisung von Ressourcen für Arbeiten, die außerhalb des kosmologischen Mainstreams liegen, und betrachten dies als nutzlose Geldverschwendung. Vor einigen Jahren erreichten die Spannungen ein solches Ausmaß, dass eine Gruppe von Kosmologen in der Zeitschrift New Scientist einen sehr harten „Offenen Brief an die wissenschaftliche Gemeinschaft“ schrieb. Sie kündigte die Gründung der internationalen öffentlichen Organisation Alternative Cosmology Group (www.cosmology.info) an, die seitdem regelmäßig eigene Konferenzen abhält, die Situation jedoch bisher nicht wesentlich ändern konnte.

Die Geschichte der Wissenschaft kennt viele Fälle, in denen unerwartet ein leistungsstarkes neues Forschungsprogramm auf der Grundlage von Ideen entstand, die als zutiefst alternativ und von geringem Interesse galten. Und vielleicht trägt die gegenwärtige, disparate alternative Kosmologie den Keim einer zukünftigen Revolution im Weltbild in sich.

Modelle eines stationären Universums. Die Einzigartigkeit des Universums erlaubt keine experimentelle Überprüfung der aufgestellten Hypothesen und deren Anhebung auf die Ebene von Theorien, daher kann die Entwicklung des Universums nur im Rahmen von Modellen betrachtet werden.

Nach der Entstehung der klassischen Mechanik basierte das wissenschaftliche Weltbild auf Newtons Vorstellungen über Raum, Zeit und Schwerkraft und beschrieb eine Konstante in der Zeit, d.h. stationäres, unendliches Universum, geschaffen vom Schöpfer.

Im 20. Jahrhundert Es sind neue theoretische Grundlagen für die Erstellung neuer kosmologischer Modelle entstanden.

Zunächst müssen wir das kosmologische Postulat erwähnen, wonach die in einem begrenzten Teil des Universums aufgestellten physikalischen Gesetze für das gesamte Universum gelten. Darüber hinaus gilt die Homogenität und Isotropie der großräumigen Materieverteilung im Universum als Axiom. In diesem Fall muss das Evolutionsmodell dem sogenannten anthropischen Prinzip entsprechen, d.h. die Möglichkeit vorsehen, dass ein Beobachter (eine vernünftige Person) auf einer bestimmten Stufe der Evolution erscheint.

Denn es ist die Schwerkraft, die die Wechselwirkung der Massen in großen Entfernungen bestimmt, den theoretischen Kern der Kosmologie des 20. Jahrhunderts. wurde zur relativistischen Theorie der Schwerkraft und Raumzeit – der allgemeinen Relativitätstheorie. Nach dieser Theorie bestimmen die Verteilung und Bewegung der Materie die geometrischen Eigenschaften der Raumzeit und hängen gleichzeitig selbst von ihnen ab. Das Gravitationsfeld manifestiert sich als „Krümmung“ der Raumzeit. In Einsteins erstem kosmologischen Modell, das 1916 auf der Grundlage der Allgemeinen Relativitätstheorie erstellt wurde, ist das Universum ebenfalls stationär. Es ist grenzenlos, aber geschlossen und hat endliche Dimensionen. Der Raum schließt sich in sich selbst.

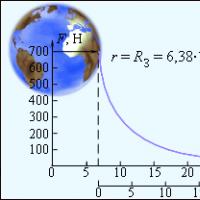

Friedman-Modelle eines instationären Universums. Einsteins Modell eines stationären Universums wurde in den Werken des russischen Wissenschaftlers A.A. widerlegt. Friedman (1888 - 1925), der 1922 zeigte, dass der gekrümmte Raum nicht stationär sein kann: Er muss sich entweder ausdehnen oder zusammenziehen. Abhängig von der durchschnittlichen Dichte der darin enthaltenen Materie sind drei verschiedene Modelle für Änderungen des Krümmungsradius des Universums möglich. In zwei davon dehnt sich das Universum unendlich aus, und im dritten ändert sich der Krümmungsradius periodisch (das Universum). pulsiert).

Obwohl E. Hubbles Entdeckung des Gesetzes der Abhängigkeit der Entfernungsgeschwindigkeit von Galaxien von der Entfernung zu ihnen die Expansion des Universums bestätigte, ist derzeit ein Vergleich der experimentell geschätzten Materiedichte mit dem kritischen Wert dieses Parameters erforderlich. die den Übergang von der Expansion zur Pulsation bestimmt, ermöglicht keine eindeutige Auswahl eines Szenarios für die weitere Entwicklung. Es stellte sich heraus, dass diese beiden Werte nahe beieinander lagen, die experimentellen Daten waren jedoch nicht zuverlässig genug.

Die Expansion des Universums ist derzeit eine fundierte und allgemein anerkannte Tatsache, die es uns ermöglicht, das Alter des Universums abzuschätzen. Nach den gängigsten Schätzungen beträgt sie 10 18 s (18 Milliarden Jahre). Daher gehen moderne Modelle von einem „Anfang“ des Universums aus. Wie begann seine Entwicklung?

Modell eines heißen Universums. Die Grundlage moderner Vorstellungen über die Anfangsstadien der Entwicklung des Universums ist das Modell des „heißen Universums“ oder „Urknalls“, dessen Grundlagen in den 40er Jahren des 20. Jahrhunderts gelegt wurden. Russischer Wissenschaftler, der in den USA arbeitet, G.A. Gammow (1904 – 1968). In der einfachsten Version dieses Modells scheint es, dass das Universum spontan als Ergebnis einer Explosion aus einem superdichten und superheißen Zustand mit unendlicher Raumkrümmung (Singularitätszustand) entstanden ist. Die „Heißheit“ des anfänglichen singulären Zustands ist durch das Überwiegen der elektromagnetischen Strahlung darin gegenüber der Materie gekennzeichnet. Dies wird durch die experimentelle Entdeckung isotroper elektromagnetischer „Reliktstrahlung“ im Jahr 1965 durch die amerikanischen Astrophysiker Penzias (geb. 1933) und Wilson (geb. 1936) bestätigt. Moderne physikalische Theorien ermöglichen es, die Entwicklung der Materie vom Augenblick der Zeit an zu beschreiben T= 10 -43 s. Die allerersten Momente der Entwicklung des Universums liegen noch hinter der physischen Barriere. Erst ab dem Moment T= 10 -10 s nach dem Urknall können unsere Vorstellungen über den Zustand der Materie im frühen Universum und die darin ablaufenden Prozesse experimentell überprüft und theoretisch beschrieben werden.

Wenn sich das Universum ausdehnt, nimmt die Dichte der darin enthaltenen Materie ab und die Temperatur sinkt. In diesem Fall kommt es zu Prozessen qualitativer Transformationen von Materieteilchen. Bei 10 -10 s besteht Materie aus freien Quarks, Leptonen und Photonen (siehe Abschnitt III). Wenn das Universum abkühlt, bilden sich Hadronen, dann erscheinen Kerne leichter Elemente – Isotope von Wasserstoff, Helium, Lithium. Die Synthese von Heliumkernen stoppt derzeit T= 3 Min. Erst nach Hunderttausenden von Jahren verbinden sich Kerne mit Elektronen zu Wasserstoff- und Heliumatomen, und von diesem Moment an hört die Substanz auf, mit elektromagnetischer Strahlung zu interagieren. Genau in dieser Zeit entstand die „Relikt“-Strahlung. Als die Größe des Universums etwa 100-mal kleiner war als heute, entstanden Gasklumpen aus Inhomogenitäten von Wasserstoff- und Heliumgas, die fragmentierten und zur Entstehung von Sternen und Galaxien führten.

Die Frage nach der Exklusivität des Universums als Objekt der Kosmologie bleibt offen. Neben der weit verbreiteten Ansicht, dass das gesamte Universum unsere Metagalaxie ist, gibt es die gegenteilige Meinung, dass das Universum aus vielen Metagalaxien bestehen kann und die Vorstellung von der Einzigartigkeit des Universums historisch relativ ist und durch die Ebene bestimmt wird von Wissenschaft und Praxis.

Historisch gesehen haben sich Vorstellungen über das Universum immer im Rahmen mentaler Modelle des Universums entwickelt, beginnend mit antiken Mythen. In der Mythologie fast aller Nationen nehmen Mythen über das Universum – seinen Ursprung, sein Wesen, seine Struktur, seine Beziehungen und mögliche Ursachen für das Ende – einen bedeutenden Platz ein. In den meisten antiken Mythen ist die Welt (das Universum) nicht ewig, sie wurde von höheren Mächten aus einem Grundprinzip (Substanz) erschaffen, normalerweise aus Wasser oder aus Chaos. Die Zeit ist in alten kosmogonischen Vorstellungen meist zyklisch, d.h. Die Ereignisse von Geburt, Existenz und Tod des Universums folgen einander in einem Kreis, wie bei allen Objekten in der Natur. Das Universum ist ein einziges Ganzes, alle seine Elemente sind miteinander verbunden, die Tiefe dieser Verbindungen variiert bis hin zu möglichen gegenseitigen Transformationen, Ereignisse folgen aufeinander und ersetzen einander (Winter und Sommer, Tag und Nacht). Diese Weltordnung ist dem Chaos entgegengesetzt. Der Raum der Welt ist begrenzt. Höhere Mächte (manchmal Götter) fungieren entweder als Schöpfer des Universums oder als Wächter der Weltordnung. Die Struktur des Universums in Mythen geht von Vielschichtigkeit aus: Neben der offenbarten (mittleren) Welt gibt es die Ober- und Unterwelt, die Achse des Universums (oft in Form eines Weltenbaums oder Berges), das Zentrum von Die Welt ist ein Ort, der mit besonderen heiligen Eigenschaften ausgestattet ist. Zwischen den einzelnen Schichten der Welt besteht eine Verbindung. Die Existenz der Welt wird regressiv gedacht – vom „goldenen Zeitalter“ bis zum Untergang und Tod. In antiken Mythen kann der Mensch ein Analogon zum gesamten Kosmos sein (die ganze Welt wird aus einem gigantischen Wesen erschaffen, das einem riesigen Menschen ähnelt), was die Verbindung zwischen Mensch und Universum stärkt. In antiken Modellen steht der Mensch nie im Mittelpunkt. Im VI-V Jahrhundert. Chr. Die ersten naturphilosophischen Modelle des Universums werden erstellt, die meisten davon wurden im antiken Griechenland entwickelt. Das ultimative Konzept in diesen Modellen ist der Kosmos als ein einziges Ganzes, schön und gesetzeskonform. Die Frage, wie die Welt entstanden ist, wird ergänzt durch die Frage, woraus die Welt besteht und wie sie sich verändert. Die Antworten werden nicht mehr in bildlicher, sondern in abstrakter, philosophischer Sprache formuliert. Die Zeit in Modellen ist meist noch zyklischer Natur, aber der Raum ist endlich. Die Substanz fungiert als einzelne Elemente (Wasser, Luft, Feuer – in der Milesian-Schule und bei Heraklit), eine Mischung von Elementen und ein einziger, unteilbarer, bewegungsloser Kosmos (bei den Eleaten), ontologisierte Zahl (bei den Pythagoräern), unteilbar Struktureinheiten – Atome, die die Einheit der Welt gewährleisten – bei Demokrit. Es ist Demokrits Modell des Universums, das im Raum unendlich ist. Naturphilosophen bestimmten den Status kosmischer Objekte – Sterne und Planeten, die Unterschiede zwischen ihnen, ihre Rolle und relative Position im Universum. Bei den meisten Modellen spielt Bewegung eine wesentliche Rolle. Der Kosmos ist nach einem einzigen Gesetz aufgebaut – dem Logos, und auch der Mensch unterliegt demselben Gesetz – einem Mikrokosmos, einer reduzierten Kopie des Kosmos. Die Entwicklung pythagoräischer Ansichten, die den Kosmos geometrisierten und ihn erstmals klar in Form einer um ein zentrales Feuer kreisenden und von diesem umgebenen Kugel darstellten, fand ihren Niederschlag in Platons späteren Dialogen. Viele Jahrhunderte lang galt das von Ptolemäus mathematisch verarbeitete Modell des Aristoteles als logischer Höhepunkt der antiken Ansichten über den Kosmos. In etwas vereinfachter Form hielt dieses Modell, unterstützt durch die Autorität der Kirche, etwa zweitausend Jahre. Nach Aristoteles ist das Universum: o ein umfassendes Ganzes, bestehend aus der Gesamtheit aller wahrgenommenen Körper; o einzigartig; o ist räumlich endlich, auf die äußerste Himmelssphäre beschränkt, dahinter „gibt es weder Leere noch Raum“; o ewig, anfangslos und endlos in der Zeit. Gleichzeitig ist die Erde bewegungslos und befindet sich im Zentrum des Universums, das Irdische und das Himmlische (supralunar) sind in ihrer physikalischen und chemischen Zusammensetzung und der Art der Bewegung absolut gegensätzlich. Im 15. und 16. Jahrhundert, während der Renaissance, tauchten naturphilosophische Modelle des Universums wieder auf. Sie zeichnen sich einerseits durch eine Rückbesinnung auf die Breite und philosophischen Ansichten der Antike und andererseits durch eine strenge Logik und Mathematik aus dem Mittelalter aus. Als Ergebnis theoretischer Forschung schlagen Nikolai Kuzansky, N. Copernicus und G. Bruno Modelle des Universums mit unendlichem Raum, irreversibler linearer Zeit, einem heliozentrischen Sonnensystem und vielen ähnlichen Welten vor. G. Galileo setzte diese Tradition fort und untersuchte die Bewegungsgesetze – die Eigenschaft der Trägheit – und war der erste, der bewusst mentale Modelle (Konstrukte, die später zur Grundlage der theoretischen Physik wurden) verwendete, eine mathematische Sprache, die er als die universelle Sprache betrachtete des Universums, eine Kombination aus empirischen Methoden und einer theoretischen Hypothese, die durch Erfahrung bestätigt oder widerlegt werden sollte, und schließlich astronomische Beobachtungen mit einem Teleskop, die die Möglichkeiten der Wissenschaft erheblich erweiterten. G. Galileo, R. Descartes, I. Kepler legten den Grundstein für moderne physikalische und kosmogonische Weltvorstellungen, sowohl auf ihrer Grundlage als auch auf der Grundlage der von Newton Ende des 17. Jahrhunderts entdeckten Gesetze der Mechanik. Es entstand das erste wissenschaftliche kosmologische Modell des Universums, das sogenannte klassische Newtonsche Modell. Nach diesem Modell ist das Universum: O statisch (stationär), d. h. im Zeitverlauf konstant; O ist homogen – alle seine Punkte sind gleich; O ist isotrop – alle Richtungen sind gleich; o ist ewig und räumlich unendlich, und Raum und Zeit sind absolut – sie hängen nicht voneinander und von bewegten Massen ab; O hat eine Materiedichte ungleich Null; O hat eine Struktur, die in der Sprache des bestehenden Systems des physikalischen Wissens vollständig verständlich ist, was die unendliche Extrapolierbarkeit der Gesetze der Mechanik, des Gesetzes der universellen Gravitation, bedeutet, die die Grundgesetze für die Bewegung aller kosmischen Körper sind. Darüber hinaus gilt im Universum das Prinzip der Fernwirkung, d.h. sofortige Signalausbreitung; Die Einheit des Universums wird durch eine einzige Struktur gewährleistet – die atomare Struktur der Materie. Die empirische Grundlage dieses Modells bildeten alle aus astronomischen Beobachtungen gewonnenen Daten, zu deren Verarbeitung moderne mathematische Geräte eingesetzt wurden. Diese Konstruktion basierte auf dem Determinismus und Materialismus der rationalistischen Philosophie des New Age. Trotz der auftretenden Widersprüche (photometrische und gravitative Paradoxien – Folgen der Extrapolation des Modells ins Unendliche) machten seine ideologische Attraktivität und logische Konsistenz sowie sein heuristisches Potenzial das Newtonsche Modell bis zum 20. Jahrhundert zum einzig akzeptablen Modell für Kosmologen. Die Notwendigkeit, die Ansichten über das Universum zu überarbeiten, wurde durch zahlreiche Entdeckungen des 19. und 20. Jahrhunderts ausgelöst: das Vorhandensein von Lichtdruck, die Teilbarkeit des Atoms, der Massendefekt, das Modell der Atomstruktur, das Nichtplanare Geometrien von Riemann und Lobatschewski, aber erst mit dem Aufkommen der Relativitätstheorie wurde eine neue quantenrelativistische Theorie zu einem möglichen Modell des Universums. Aus den Gleichungen der speziellen (STR, 1905) und allgemeinen (GR, 1916) Relativitätstheorie von A. Einstein folgt, dass Raum und Zeit in einer einzigen Metrik miteinander verbunden sind und von der Bewegung der Materie abhängen: bei Geschwindigkeiten nahe der Geschwindigkeit Durch die Einwirkung von Licht wird der Raum komprimiert, die Zeit gedehnt und in der Nähe kompakter, mächtiger Massen wird die Raumzeit gekrümmt, wodurch das Modell des Universums geometrisiert wird. Es gab sogar Versuche, sich das gesamte Universum als gekrümmte Raumzeit vorzustellen, deren Knoten und Defekte als Massen interpretiert wurden. Als Einstein Gleichungen für das Universum löste, erhielt er ein räumlich begrenztes und stationäres Modell. Um jedoch die Stationarität aufrechtzuerhalten, musste er einen zusätzlichen Lambda-Term in die Lösung einführen, der durch nichts empirisch gestützt wurde und in seiner Wirkung einem Feld entsprach, das der Schwerkraft in kosmologischen Entfernungen entgegenwirkt. Allerdings in den Jahren 1922-1924. A.A. Friedman schlug eine andere Lösung für diese Gleichungen vor, aus der es möglich war, je nach Dichte der Materie drei verschiedene Modelle des Universums zu erhalten, aber alle drei Modelle waren instationär (sich entwickelnd) – ein Modell mit Expansion, gefolgt von Kompression, an oszillierendes Modell und ein Modell mit unendlicher Ausdehnung. Damals war die Ablehnung der Stationarität des Universums ein wahrhaft revolutionärer Schritt und wurde von Wissenschaftlern mit großen Schwierigkeiten akzeptiert, da sie allen etablierten wissenschaftlichen und philosophischen Ansichten über die Natur zu widersprechen schien und unweigerlich zum Kreationismus führte. Die erste experimentelle Bestätigung der instationären Natur des Universums wurde 1929 erhalten – Hubble entdeckte eine Rotverschiebung in den Spektren entfernter Galaxien, die laut Doppler-Effekt auf die Expansion des Universums hinwies (nicht alle Kosmologen teilten diese Interpretation). diese Zeit). 1932-1933 Der belgische Theoretiker J. Lemaitre schlug ein Modell des Universums mit einem „heißen Anfang“, dem sogenannten „Urknall“, vor. Aber zurück in den 1940er und 1950er Jahren. Es wurden alternative Modelle vorgeschlagen (mit der Geburt von Teilchen aus dem C-Feld, aus dem Vakuum), die die stationäre Natur des Universums bewahren. Im Jahr 1964 entdeckten amerikanische Wissenschaftler – der Astrophysiker A. Penzias und der Radioastronom K. Wilson – eine homogene isotrope Reliktstrahlung, die eindeutig auf einen „heißen Anfang“ des Universums hinweist. Dieses Modell setzte sich durch und wurde von den meisten Kosmologen akzeptiert. Allerdings führte genau dieser „Anfangspunkt“, der Punkt der Singularität, zu vielen Problemen und Streitigkeiten, sowohl über den Mechanismus des „Urknalls“ als auch, weil das Verhalten des Systems (des Universums) in seiner Nähe nicht darin beschrieben werden konnte im Rahmen bekannter wissenschaftlicher Theorien (unendlich hohe Temperatur und Dichte mussten mit unendlich kleinen Größen kombiniert werden). Im 20. Jahrhundert Es wurden viele Modelle des Universums vorgeschlagen – von solchen, die die Relativitätstheorie als Grundlage ablehnten, bis hin zu solchen, die einen Faktor im Grundmodell veränderten, zum Beispiel die „Zellstruktur des Universums“ oder die Stringtheorie. Um also die mit der Singularität verbundenen Widersprüche in den Jahren 1980-1982 zu beseitigen. Der amerikanische Astronom P. Steinhart und der sowjetische Astrophysiker A. Linde schlugen eine Modifikation des Modells des expandierenden Universums vor – ein Modell mit einer Inflationsphase (das „inflating Universe“-Modell), bei dem die ersten Momente nach dem „Urknall“ a erhielten neue Interpretation. Dieses Modell wurde später immer weiter verfeinert; es beseitigte eine Reihe bedeutender Probleme und Widersprüche in der Kosmologie. Die Forschung hört heute nicht auf: Die von einer Gruppe japanischer Wissenschaftler aufgestellte Hypothese über den Ursprung primärer Magnetfelder stimmt gut mit dem oben beschriebenen Modell überein und lässt uns hoffen, neue Erkenntnisse über die frühen Stadien der Existenz des zu gewinnen Universum. Als Untersuchungsobjekt ist das Universum zu komplex, um deduktiv untersucht zu werden; Methoden der Extrapolation und Modellierung bieten die Möglichkeit, sein Wissen voranzutreiben. Diese Methoden erfordern jedoch die strikte Einhaltung aller Verfahren (von der Problemformulierung, der Auswahl der Parameter, dem Grad der Ähnlichkeit zwischen Modell und Original bis hin zur Interpretation der erzielten Ergebnisse), und selbst wenn alle Anforderungen optimal erfüllt sind, werden die Forschungsergebnisse dies tun grundsätzlich probabilistischer Natur sein. Die Mathematisierung von Wissen, die die heuristischen Fähigkeiten vieler Methoden deutlich verbessert, ist ein allgemeiner Trend in der Wissenschaft des 20. Jahrhunderts. Die Kosmologie bildete keine Ausnahme: Es entstand eine Art mentaler Modellierung – die mathematische Modellierung, die Methode der mathematischen Hypothese. Sein Kern besteht darin, dass zunächst Gleichungen gelöst werden und dann nach einer physikalischen Interpretation der resultierenden Lösungen gesucht wird. Dieses für die Wissenschaft der Vergangenheit untypische Verfahren birgt ein enormes heuristisches Potenzial. Es war diese Methode, die Friedman dazu veranlasste, ein Modell des expandierenden Universums zu erstellen; auf diese Weise wurde das Positron entdeckt und am Ende des 20. Jahrhunderts wurden in der Wissenschaft viele weitere wichtige Entdeckungen gemacht. Computermodelle, einschließlich derjenigen, die zur Modellierung des Universums verwendet werden, sind das Ergebnis der Entwicklung der Computertechnologie. Darauf aufbauend wurden Modelle des Universums mit einer Inflationsphase verbessert; zu Beginn des 21. Jahrhunderts. Große Mengen der von der Raumsonde empfangenen Informationen wurden verarbeitet und ein Modell der Entwicklung des Universums unter Berücksichtigung von „Dunkler Materie“ und „Dunkler Energie“ erstellt. Im Laufe der Zeit hat sich die Interpretation vieler grundlegender Konzepte geändert. Das physikalische Vakuum wird nicht mehr als Leere, nicht als Äther verstanden, sondern als komplexer Zustand mit einem potentiellen (virtuellen) Inhalt von Materie und Energie. Gleichzeitig wurde entdeckt, dass die der modernen Wissenschaft bekannten kosmischen Körper und Felder einen unbedeutenden Prozentsatz der Masse des Universums ausmachen und der größte Teil der Masse in „dunkler Materie“ und „dunkler Energie“ enthalten ist, die indirekt aufschlussreich sind sich. Forschungen der letzten Jahre haben gezeigt, dass ein erheblicher Teil dieser Energie auf die Expansion, Dehnung und Zerreißung des Universums einwirkt, was zu einer festen Beschleunigung der Expansion führen kann.

Bewegung von Körpern unter dem Einfluss der Schwerkraft

Bewegung von Körpern unter dem Einfluss der Schwerkraft Tropen und Stilfiguren

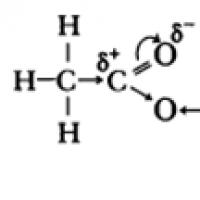

Tropen und Stilfiguren §12. Carbonsäuren. Carbonsäuren: physikalische Eigenschaften. Salze von Carbonsäuren Die einfachste Carbonsäure ist Ameisensäure

§12. Carbonsäuren. Carbonsäuren: physikalische Eigenschaften. Salze von Carbonsäuren Die einfachste Carbonsäure ist Ameisensäure Gespräch mit Ex-Freundin

Gespräch mit Ex-Freundin Warum träumst du von deinem besten Freund, Ex-Freund oder Jugendfreund?

Warum träumst du von deinem besten Freund, Ex-Freund oder Jugendfreund? Traumdeutung: Eine schwangere Frau träumt von einem Kind

Traumdeutung: Eine schwangere Frau träumt von einem Kind Warum träumen Sie von Funkenstrom? Warum träumst du von Funken? Was schreiben sie in Traumbücher?

Warum träumen Sie von Funkenstrom? Warum träumst du von Funken? Was schreiben sie in Traumbücher?